Robots.txt là gì? Hướng dẫn tạo file robots.txt nhanh chóng

Trong thế giới quản trị website và tối ưu hóa SEO, file robots.txt là công cụ thiết yếu giúp bạn kiểm soát cách các công cụ tìm kiếm thu thập dữ liệu trên trang web. Vậy robots.txt là gì? Đây là một tệp văn bản đơn giản cho phép bạn chỉ định những phần của website mà bot tìm kiếm được phép hoặc không được truy cập. Mặc dù không phải là phương tiện bảo mật tuyệt đối nhưng khi được cấu hình đúng cách, robots.txt sẽ giúp bảo vệ các nội dung nhạy cảm và tối ưu hóa hiệu quả lập chỉ mục. Bài viết này sẽ hướng dẫn tạo file robots.txt nhanh chóng và dễ dàng, từ khâu tạo file, thiết lập quy tắc, kiểm tra tính chính xác cho đến việc tải lên máy chủ – nhằm đảm bảo website của bạn hoạt động hiệu quả nhất.

Robots.txt là gì?

Robots.txt là một tệp văn bản đơn giản được đặt trong thư mục gốc của website nhằm hướng dẫn các công cụ tìm kiếm (crawlers) về những phần của trang web mà chúng được phép hoặc không được phép thu thập dữ liệu (crawl) và lập chỉ mục (index). Robots.txt dùng để:

- Kiểm soát quyền truy cập của bot tìm kiếm: Ngăn chặn bot thu thập dữ liệu ở những trang không cần thiết như trang quản trị, giỏ hàng hoặc trang nội bộ.

- Bảo vệ nội dung nhạy cảm: Giúp ngăn chặn việc lập chỉ mục nội dung không muốn xuất hiện trên công cụ tìm kiếm.

- Tối ưu hóa ngân sách thu thập dữ liệu (Crawl Budget): Chỉ định những trang quan trọng để Googlebot tập trung thu thập dữ liệu, cải thiện tốc độ index nội dung quan trọng.

Vai trò của file robots.txt đối với website

File robots.txt đóng vai trò quan trọng trong việc quản lý các bot tìm kiếm và trình thu thập thông tin tương tác với website của bạn.

- Điều khiển quá trình crawl: Cho phép bạn chỉ định những phần nào của website có thể được thu thập và những phần nào nên bỏ qua. Điều này giúp tối ưu hóa ngân sách crawl của website tránh lãng phí tài nguyên vào những trang không cần thiết.

- Ngăn chặn nội dung trùng lặp: Một số trang có thể tạo nội dung trùng lặp do tham số URL (ví dụ: ?sort=newest, ?filter=price). Bằng cách chặn các URL không cần thiết, robots.txt giúp tránh tình trạng Google lập chỉ mục nhiều phiên bản của cùng một nội dung, giảm nguy cơ bị phạt vì nội dung trùng lặp (Duplicate Content).

- Bảo vệ nội dung riêng tư: Bảo vệ nội dung riêng tư có thể chặn bot truy cập vào các trang quản trị, giỏ hàng, trang nội bộ hoặc tài liệu nhạy cảm.

- Tối ưu hóa tài nguyên máy chủ: Bằng cách hạn chế bot truy cập vào các trang không quan trọng, tránh tình trạng lãng phí tài nguyên. Đặc biệt hữu ích cho các website lớn có hàng nghìn trang, nơi bot crawl tìm kiếm có thể tiêu tốn nhiều băng thông nếu không được kiểm soát.

- Chỉ dẫn đến sitemap: Bot tìm kiếm cung cấp đường dẫn đến file sitemap.xml, giúp các công cụ tìm kiếm hiểu cấu trúc của website tốt hơn.

Cấu trúc cơ bản của một file robots.txt

Cấu trúc cơ bản của một file robots.txt thường bao gồm các chỉ thị sau:

- User-agent: Chỉ định trình thu thập dữ liệu (crawler) mà các chỉ thị sau áp dụng. Ví dụ, User-agent: * có nghĩa là áp dụng cho tất cả các bot.

- Disallow: Xác định các đường dẫn hoặc thư mục mà bạn không muốn bot truy cập. Ví dụ, Disallow: /admin/ sẽ ngăn bot truy cập thư mục /admin/.

- Allow: (Tùy chọn) Cho phép truy cập vào một số phần của một thư mục đã bị chặn bởi chỉ thị Disallow.

- Các dòng chú thích: Bắt đầu bằng dấu # để giải thích thêm về mục đích của các chỉ thị.

Ví dụ mẫu:

# Hướng dẫn cho tất cả các bot

User-agent: *

Disallow: /private/

Allow: /private/public/

Sitemap: https://example.com/sitemap.xml

Hướng dẫn tạo file robots.txt cho website

Nếu bạn tạo file robots.txt cho website không quá phức tạp. Nếu kiểm tra chưa có file robots.txt, bạn có thể làm theo hướng dẫn tạo file robots.txt cho website dưới đây để thực hiện nhanh chóng, dễ dàng.

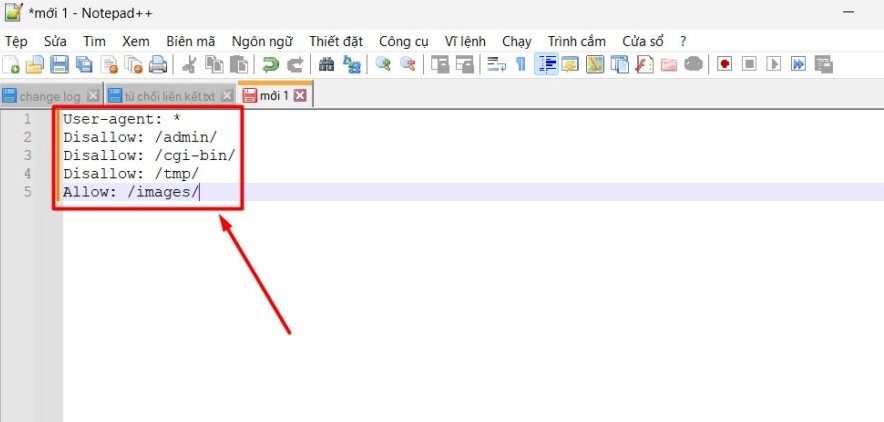

1. Tạo file robots.txt

Tệp robots.txt là một tệp văn bản đơn giản, có thể tạo bằng bất kỳ trình soạn thảo văn bản nào như Notepad, VS Code, Sublime Text hoặc sử dụng cPanel, FTP để tạo trực tiếp trên máy chủ.

Để tạo file robots.txt cho website, bạn cần:

- Mở Notepad (hoặc bất kỳ trình soạn thảo văn bản nào).

- Sau đó, bạn nhập nội dung theo định dạng phù hợp (hướng dẫn chi tiết bên dưới).

- Lưu file với tên "robots.txt" (lưu ý phải là đuôi .txt).

2. Cấu hình quy tắc cho file robots.txt

Trong file robots.txt, bạn có thể sử dụng các lệnh để kiểm soát quyền truy cập của bot:

|

Lệnh |

Mã lệnh |

|

Chặn toàn bộ trang web |

User-agent: * Disallow: / |

|

Cho phép tất cả bot thu thập dữ liệu |

User-agent: * Disallow: |

|

Chặn một thư mục cụ thể |

User-agent: * Disallow: |

|

Chặn một trang cụ thể |

User-agent: * Disallow: /private/ |

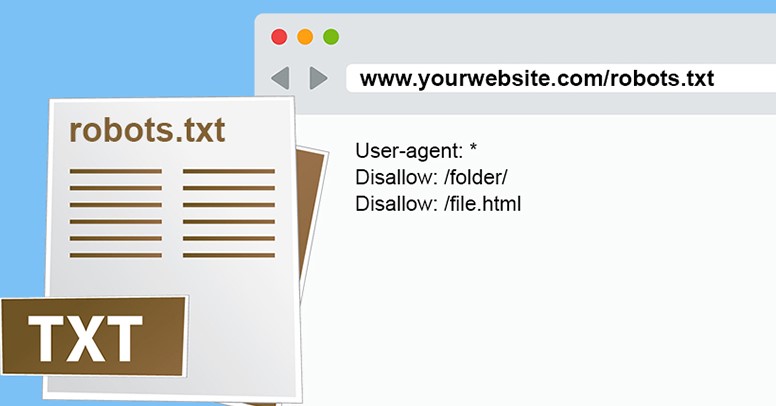

3. Kiểm tra file robots.txt

Sau khi tạo và cấu hình, bạn cần kiểm tra xem file robots.txt có hoạt động đúng hay không:

- Truy cập file bằng trình duyệt: Mở https://yourwebsite.com/robots.txt để kiểm tra nội dung.

- Dùng Google Search Console: Công cụ Robots.txt Tester giúp kiểm tra lỗi và xác thực quy tắc.

- Kiểm tra với công cụ bên thứ ba: Một số công cụ hỗ trợ như SEO Site Checkup, Ahrefs, Screaming Frog.

Một số câu hỏi thường gặp về file robots.txt

File robots.txt đóng vai trò quan trọng trong việc kiểm soát quá trình thu thập dữ liệu của công cụ tìm kiếm. Việc hiểu và sử dụng đúng sẽ giúp tối ưu hóa SEO và bảo vệ nội dung trang web. Dưới đây là một số câu hỏi về file robot.txt giúp bạn có cái nhìn tổng quan nhất.

1. Sự khác biệt giữa "Disallow" và "Noindex" là gì?

"Disallow" và "Noindex" đều được sử dụng để kiểm soát cách công cụ tìm kiếm xử lý trang web, nhưng chúng có mục đích và cách hoạt động khác nhau:

- Disallow (trong file robots.txt): Ngăn công cụ tìm kiếm thu thập dữ liệu một URL cụ thể nhưng không ngăn chặn việc trang đó xuất hiện trên kết quả tìm kiếm nếu đã được lập chỉ mục trước đó.

- Noindex (trong meta robots hoặc HTTP header): Chặn trang web không được lập chỉ mục, nghĩa là trang sẽ không xuất hiện trên kết quả tìm kiếm.

Nếu muốn một trang không hiển thị trên kết quả tìm kiếm nên sử dụng "Noindex" thay vì chỉ chặn bằng "Disallow".

2. Làm sao để cho phép một bot cụ thể truy cập nhưng chặn bot khác?

Trong file robots.txt, có thể sử dụng các quy tắc khác nhau cho từng bot bằng cách chỉ định tên của chúng. Ví dụ:

User-agent: Googlebot

Disallow:

User-agent: Bingbot

Disallow: /

Tức là:

- Googlebot (bot của Google) được phép thu thập toàn bộ website.

- Bingbot (bot của Bing) bị chặn hoàn toàn.

Điều này giúp kiểm soát tốt hơn quyền truy cập của từng bot vào trang web.

3. File robots.txt ảnh hưởng thế nào đến SEO và lập chỉ mục trang web?

File robots.txt ảnh hưởng đến SEO theo nhiều cách:

- Kiểm soát thu thập dữ liệu (Crawl Budget): Giúp công cụ tìm kiếm tập trung vào những trang quan trọng thay vì lãng phí tài nguyên vào trang không cần thiết.

- Ngăn lập chỉ mục nội dung nhạy cảm: Dùng để chặn trang quản trị viên, tài nguyên nội bộ, hoặc nội dung trùng lặp.

- Ảnh hưởng đến việc hiển thị trên Google: Nếu chặn trang quan trọng bằng "Disallow", công cụ tìm kiếm có thể không lập chỉ mục hoặc hiển thị trang đó không đầy đủ.

File robots.txt không chỉ giúp bạn kiểm soát quyền truy cập của các bot tìm kiếm mà còn là một công cụ hỗ trợ tối ưu hóa SEO quan trọng cho website. Bằng cách định cấu hình đúng các quy tắc, bạn có thể hướng dẫn các trình thu thập thông tin tập trung vào nội dung cần thiết và bảo vệ các phần trang nhạy cảm. Hy vọng bài viết của Website Chuyên Nghiệp đã cung cấp cho bạn cái nhìn tổng quan cũng như các bước thực hiện chi tiết để tạo và quản lý file robots.txt một cách hiệu quả, góp phần nâng cao hiệu suất hoạt động và vị thế của website trên các công cụ tìm kiếm.

Bài viết liên quan:

![]() Downtime là gì? Nguyên nhân, hậu quả và giải pháp khắc phục

Downtime là gì? Nguyên nhân, hậu quả và giải pháp khắc phục

![]() DDoS là gì? Phương thức tấn công DDoS và cách phòng tránh

DDoS là gì? Phương thức tấn công DDoS và cách phòng tránh

![]() Website development là gì? Quy trình phát triển web từ A đến Z

Website development là gì? Quy trình phát triển web từ A đến Z

Tin tức khác | Xem tất cả