Web Scraping là gì? Nguyên lý hoạt động và công cụ phổ biến

Trong thời đại dữ liệu số, thông tin trên internet trở thành nguồn tài nguyên quý giá phục vụ cho nghiên cứu, phân tích thị trường, marketing và phát triển sản phẩm. Tuy nhiên, việc thu thập dữ liệu từ các trang web một cách thủ công không chỉ tốn thời gian mà còn dễ mắc lỗi. Đây chính là lúc web scraping trở thành một công cụ quan trọng, giúp tự động hóa quá trình thu thập dữ liệu một cách nhanh chóng và chính xác.

Bài viết này sẽ giúp bạn hiểu rõ web scraping là gì, tại sao lại cần thiết và làm thế nào xây dựng một quy trình web scraping hiệu quả với các thư viện mạnh mẽ như BeautifulSoup, Scrapy hay Selenium. Dù bạn là người mới bắt đầu hay đã có chút nền tảng, bài viết sẽ cung cấp cho bạn lộ trình rõ ràng và dễ thực hiện để thu thập dữ liệu một cách chính xác và hợp lý.

Web scraping là gì?

Web scraping (hay còn gọi là thu thập dữ liệu web) là quá trình tự động trích xuất thông tin từ các trang web. Thay vì phải sao chép thủ công từng dòng dữ liệu, các công cụ hoặc đoạn mã lập trình sẽ được sử dụng để truy cập, phân tích cấu trúc HTML của website và lấy về các thông tin cần thiết như văn bản, hình ảnh, liên kết, bảng biểu,....

Khác với web crawling chú trọng việc duyệt qua nhiều trang để thu thập URL hoặc cấu trúc trang, scraping lại tập trung vào những dữ liệu có cấu trúc cụ thể ví dụ như giá, tiêu đề, mô tả sản phẩm,.... Web data scraping thường được áp dụng trong nhiều lĩnh vực như phân tích thị trường, so sánh giá cả, nghiên cứu đối thủ, theo dõi tin tức và xây dựng cơ sở dữ liệu từ nguồn mở (open data).

Lợi ích của web scraping trong thời đại dữ liệu số

Trong bối cảnh dữ liệu trở thành “tài nguyên mới” của thế kỷ 21, web scraping đóng vai trò ngày càng quan trọng trong việc khai thác thông tin hiệu quả từ internet. Các doanh nghiệp, tổ chức nghiên cứu và cá nhân có thể tận dụng công nghệ này cùng với các scraper hiện đại để nắm bắt cơ hội, tối ưu hoá hoạt động và đưa ra quyết định chính xác hơn.

1. Tự động hóa thu thập dữ liệu lớn

Trước đây, thu thập dữ liệu từ hàng trăm hay hàng nghìn trang web yêu cầu rất nhiều thời gian và nhân lực. Với sự hỗ trợ của các web scraper, quy trình này được thực hiện một cách nhanh chóng và nhất quán. Các scraper có thể duyệt qua hàng loạt trang, phân tích cấu trúc HTML, trích xuất thông tin và lưu trữ vào cơ sở dữ liệu mà không cần thao tác thủ công. Điều này cực kỳ hữu ích trong các ngành như thương mại điện tử, tài chính hay bất động sản, nơi dữ liệu thay đổi liên tục và yêu cầu cập nhật tức thì.

2. Hỗ trợ nghiên cứu thị trường, đối thủ cạnh tranh

Một trong những ứng dụng mạnh mẽ nhất của web data scraping là hỗ trợ doanh nghiệp nghiên cứu thị trường. Nhờ vào các scraper tùy chỉnh, doanh nghiệp có thể thu thập thông tin từ website của đối thủ, mạng xã hội hoặc sàn thương mại điện tử để phân tích sản phẩm, giá bán, đánh giá khách hàng hay chiến dịch truyền thông. Điều này giúp định hướng chiến lược tiếp thị, cải thiện sản phẩm và nâng cao lợi thế cạnh tranh trên thị trường.

3. Phân tích xu hướng và ra quyết định kinh doanh

Trong thời đại mà dữ liệu có thể thay đổi từng phút, việc sử dụng scraper để thu thập dữ liệu từ báo điện tử, blog, mạng xã hội hay các công cụ phân tích xu hướng như Google Trends là cực kỳ quan trọng. Các scraper giúp nhanh chóng tổng hợp thông tin, từ đó hỗ trợ doanh nghiệp phát hiện các cơ hội mới, theo dõi sự thay đổi hành vi tiêu dùng và đưa ra quyết định kinh doanh dựa trên dữ liệu thực tế thay vì chỉ dựa vào cảm tính.

4. Tối ưu SEO và theo dõi từ khóa

Các chuyên gia SEO hiện nay không thể thiếu sự hỗ trợ của SEO scraper để theo dõi thứ hạng từ khóa, phân tích nội dung của đối thủ và giám sát sự biến động của các yếu tố ảnh hưởng đến thứ hạng trang web. Scraper có thể tự động lấy dữ liệu từ kết quả tìm kiếm Google, phát hiện những từ khóa đang được sử dụng nhiều, cũng như cấu trúc nội dung chuẩn SEO. Từ đó, doanh nghiệp có thể điều chỉnh chiến lược nội dung và kỹ thuật SEO một cách chính xác và kịp thời.

Cách hoạt động của web scraping

Để hiểu rõ cách thức hoạt động của web scraping, chúng ta có thể hình dung nó như một “robot trình duyệt” thay vì con người tự mình truy cập và sao chép dữ liệu, scraper sẽ thực hiện quy trình này một cách tự động, nhanh chóng và chính xác. Dù sử dụng công cụ mã nguồn mở hay phần mềm không cần lập trình, quy trình web scraping nhìn chung đều trải qua các bước cơ bản sau:

Bước 1: Gửi request HTTP

Đầu tiên, scraper gửi một yêu cầu (request) tới máy chủ web thông qua giao thức HTTP hoặc HTTPS, tương tự như khi bạn nhập một đường dẫn vào trình duyệt. Mục tiêu là lấy được mã nguồn HTML của trang web mà scraper muốn truy xuất.

Công cụ scraper thường sử dụng các thư viện như requests (Python) hoặc axios (JavaScript) để thực hiện hành động này. Máy chủ sau đó phản hồi bằng cách trả về nội dung của trang web, chính là tài liệu HTML cần được xử lý.

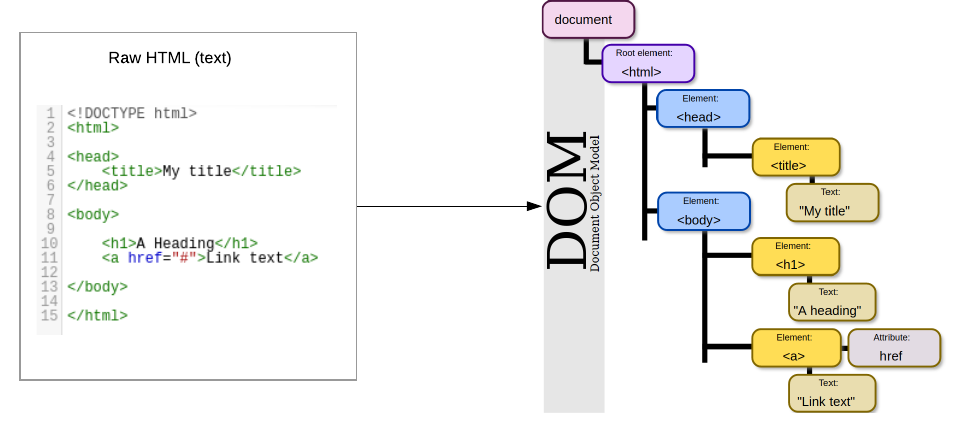

Bước 2. Phân tích HTML DOM

Sau khi nhận được nội dung HTML, scraper sẽ tiến hành phân tích DOM (Document Object Model) – một mô hình cây biểu diễn cấu trúc của trang web. Thông qua các thư viện như BeautifulSoup, lxml hoặc Cheerio, scraper có thể "hiểu" được từng phần tử trên trang: tiêu đề, bảng giá, mô tả sản phẩm, hình ảnh, v.v.

Ở bước này, lập trình viên sẽ viết các đoạn mã định vị các phần tử cụ thể bằng cách sử dụng selector như class, id, tag name hoặc XPath/CSS Selector để truy cập đến đúng dữ liệu cần thu thập.

Bước 3. Trích xuất dữ liệu

Sau khi xác định được các phần tử HTML mong muốn, scraper sẽ tiến hành trích xuất dữ liệu (data extraction). Đây là bước thu lấy nội dung nằm bên trong các thẻ HTML như < div >, < span >, < p > hoặc thậm chí là thuộc tính như href của thẻ < a >.

Dữ liệu được chuyển đổi từ dạng văn bản thô (raw text) thành định dạng có thể xử lý, chẳng hạn như chuỗi, số, ngày tháng,... Tùy thuộc vào mục tiêu, scraper có thể thu thập toàn bộ bảng dữ liệu, danh sách sản phẩm, đánh giá khách hàng hay giá bán cụ thể.

Bước 4. Lưu trữ vào cơ sở dữ liệu

Sau khi dữ liệu được trích xuất, bước cuối cùng là lưu trữ vào hệ thống để phục vụ phân tích hoặc sử dụng sau này. Scraper có thể lưu dữ liệu dưới nhiều định dạng như CSV, JSON, Excel hoặc trực tiếp đưa vào cơ sở dữ liệu quan hệ (SQL) hoặc phi quan hệ (NoSQL) như MySQL, PostgreSQL, MongoDB,... Điều này giúp dữ liệu được tổ chức một cách khoa học, dễ dàng tích hợp vào các hệ thống phân tích, dashboard trực quan hoặc pipeline học máy (machine learning pipeline).

Các công cụ web scraping phổ biến hiện nay

Trong thời đại dữ liệu số, web scraping trở thành một phương pháp hữu ích giúp thu thập thông tin tự động từ các trang web phục vụ cho nghiên cứu, marketing, phân tích dữ liệu hoặc đào tạo AI. Tùy vào nhu cầu và khả năng kỹ thuật, người dùng có thể lựa chọn công cụ data scraping phù hợp.

1. Công cụ mã nguồn mở

Đây là nhóm công cụ dành cho lập trình viên, cung cấp độ linh hoạt cao, khả năng tùy biến mạnh mẽ và thường được tích hợp tốt với các thư viện phân tích dữ liệu.

- BeautifulSoup (Python): BeautifulSoup là một thư viện nổi tiếng trong cộng đồng Python, được sử dụng để phân tích cú pháp HTML và XML. Điểm mạnh của BeautifulSoup là cú pháp đơn giản, dễ học và dễ sử dụng cho các tác vụ nhỏ hoặc các dự án cá nhân. Nó hoạt động tốt kết hợp với requests để tải trang và trích xuất dữ liệu theo cấu trúc thẻ HTML.

- Scrapy (Python): Scrapy là một framework mạnh mẽ dành cho web data scraping và crawling. Công cụ này hỗ trợ xử lý song song, quản lý yêu cầu HTTP hiệu quả và tích hợp dễ dàng với pipeline xử lý dữ liệu.

- Selenium (Python, đa ngôn ngữ): Selenium là công cụ tự động hóa trình duyệt, thường được dùng để kiểm thử web nhưng cũng rất hữu ích cho web scraping, đặc biệt khi xử lý các trang web sử dụng JavaScript động.

2. Phần mềm web scraping không cần lập trình

Dành cho người dùng không có kỹ năng lập trình, những phần mềm này thường có giao diện kéo - thả trực quan và cung cấp các tính năng tự động hóa tác vụ trích xuất dữ liệu.

- Octoparse: Octoparse là một trong những phần mềm web scraping phổ biến nhất hiện nay với giao diện thân thiện, hỗ trợ trích xuất dữ liệu từ các trang web tĩnh và động mà không cần viết mã. Người dùng chỉ cần chọn các phần tử muốn lấy dữ liệu, công cụ sẽ tự động tạo cấu trúc để thu thập.

- ParseHub: ParseHub cũng là một lựa chọn phổ biến nhờ vào khả năng xử lý JavaScript và giao diện trực quan. Nó cho phép người dùng tạo các project trích xuất dữ liệu thông qua chuỗi hành động mô phỏng việc duyệt web.

Ứng dụng thực tế của web scraping trong doanh nghiệp và nghiên cứu

Web scraping không chỉ là một công cụ kỹ thuật mà còn là nền tảng cho nhiều chiến lược kinh doanh và nghiên cứu hiện đại. Dưới đây là một số ứng dụng phổ biến:

- Phân tích đối thủ cạnh tranh: Doanh nghiệp có thể thu thập dữ liệu từ các website của đối thủ để theo dõi giá cả, chương trình khuyến mãi, sản phẩm mới hoặc đánh giá khách hàng. Điều này giúp đưa ra quyết định chiến lược kịp thời và chính xác hơn.

- So sánh giá và theo dõi thị trường: Các sàn thương mại điện tử, trang web so sánh giá (price comparison engines) sử dụng data scraping để thu thập giá từ nhiều nguồn khác nhau nhằm đưa ra bảng so sánh cho người dùng.

- Phân tích dữ liệu khách hàng: Scraping các bài đánh giá, bình luận trên mạng xã hội, diễn đàn hoặc trang thương mại điện tử giúp doanh nghiệp hiểu rõ hơn về cảm nhận và nhu cầu của khách hàng. Đây là một dạng thu thập dữ liệu phục vụ cho việc phân tích cảm xúc (sentiment analysis).

- Theo dõi tin tức và xu hướng: Các hệ thống giám sát thông tin (media monitoring) sử dụng web data scraping để quét qua hàng trăm nguồn tin, blog và mạng xã hội, từ đó nhận diện xu hướng mới, khủng hoảng truyền thông hoặc tin tức liên quan đến thương hiệu.

Những thách thức khi sử dụng web scraping

Mặc dù web data scraping mang lại nhiều lợi ích vượt trội trong việc thu thập và phân tích dữ liệu, nhưng việc triển khai scraper trong thực tế lại gặp không ít khó khăn. Từ yếu tố kỹ thuật đến pháp lý, người dùng cần nhận diện rõ những rào cản phổ biến để tránh rủi ro không mong muốn

1. Chống bot và Captcha

Nhiều website ngày nay tích hợp các cơ chế chống bot (anti-bot) để ngăn chặn các scraper tự động truy cập. Một trong những kỹ thuật phổ biến nhất là sử dụng Captcha – những bài kiểm tra yêu cầu người dùng xác minh họ không phải máy móc, như chọn hình ảnh đúng hoặc nhập ký tự. Những công cụ như Cloudflare, Akamai hoặc Google reCAPTCHA thường được triển khai để phát hiện hành vi truy cập bất thường. Khi scraper gặp Captcha, quá trình trích xuất dữ liệu có thể bị gián đoạn hoặc thậm chí bị chặn hoàn toàn nếu không có giải pháp xử lý thích hợp như sử dụng headless browser (trình duyệt không giao diện) hoặc proxy xoay vòng.

2. Website thay đổi cấu trúc thường xuyên

Một thách thức lớn khác trong web scraping là việc cấu trúc HTML của trang web thay đổi thường xuyên. Các trang thường xuyên cập nhật giao diện, thay đổi tên class, ID hoặc thứ tự hiển thị thông tin khiến các selector mà scraper sử dụng trước đó không còn hoạt động chính xác. Điều này buộc người phát triển scraper phải kiểm tra và điều chỉnh lại mã nguồn thường xuyên để đảm bảo chương trình vẫn thu thập được dữ liệu đúng định dạng. Trong các dự án lớn, điều này đòi hỏi cần có quy trình monitoring và maintenance thường xuyên.

3. Giới hạn tốc độ truy cập (Rate limiting)

Để bảo vệ tài nguyên hệ thống, nhiều website thiết lập giới hạn tốc độ truy cập (rate limiting), nghĩa là nếu một IP gửi quá nhiều request trong một khoảng thời gian ngắn, website sẽ tạm thời hoặc vĩnh viễn chặn IP đó. Scraper không tuân thủ giới hạn này có thể bị coi là có hành vi tấn công (DoS/DDoS), dẫn đến bị khóa truy cập. Để vượt qua vấn đề này, các scraper chuyên nghiệp cần tích hợp kỹ thuật như sleep time, IP rotation (xoay IP) hoặc user-agent randomization để mô phỏng hành vi truy cập của người dùng thật một cách tự nhiên và phân tán tải hợp lý.

4. Rủi ro pháp lý khi thu thập dữ liệu

Bên cạnh các thách thức kỹ thuật, web scraping cũng đối mặt với những vấn đề pháp lý đáng lưu ý. Tại một số quốc gia, việc thu thập dữ liệu từ website người khác, dù là dữ liệu công khai có thể bị coi là vi phạm quyền sở hữu trí tuệ hoặc điều khoản sử dụng (terms of service). Một số vụ kiện nổi tiếng như hiQ Labs vs. LinkedIn đã làm dấy lên nhiều tranh cãi xoay quanh quyền truy cập dữ liệu mở. Vì vậy, người thực hiện scraper cần tìm hiểu rõ các quy định pháp luật địa phương, đồng thời tôn trọng robots.txt, tệp hướng dẫn giới hạn vùng dữ liệu được phép thu thập để tránh các hệ quả pháp lý không mong muốn.

Qua bài viết của Website Chuyên Nghiệp, web scraping là một công cụ hữu ích giúp doanh nghiệp tự động hóa việc thu thập dữ liệu từ các nguồn trực tuyến, đặc biệt phù hợp khi cần theo dõi giá cả, phân tích đối thủ, nghiên cứu thị trường hoặc tối ưu chiến lược SEO. Tuy nhiên, công nghệ này không phải lúc nào cũng phù hợp, nhất là khi website mục tiêu có cơ chế chống bot phức tạp, thay đổi cấu trúc liên tục hoặc có rào cản pháp lý rõ ràng. Doanh nghiệp nên sử dụng web scraping khi có nhu cầu khai thác dữ liệu công khai một cách thường xuyên và có năng lực kỹ thuật để duy trì hệ thống scraper. Nếu không có đội ngũ in-house chuyên môn, việc thuê dịch vụ web scraping chuyên nghiệp sẽ là lựa chọn tối ưu, vừa tiết kiệm thời gian, vừa đảm bảo hiệu quả và tuân thủ quy định.

Tin tức khác | Xem tất cả